如何调用英伟达部署的deepseek-R1推理模型API ?

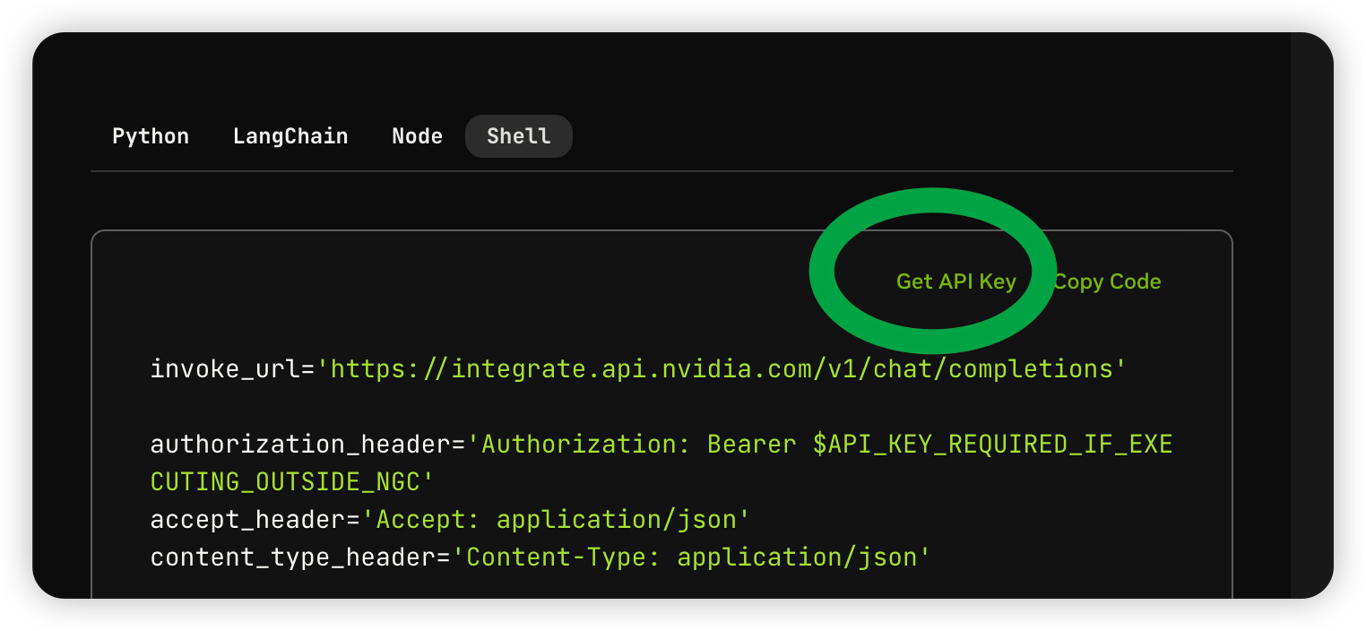

第一步:获取请求demo

切换编程语言为Shell,获取base_url、path、api_key、model这4个核心参数

invoke_url='https://integrate.api.nvidia.com/v1/chat/completions'

authorization_header='Authorization: Bearer $API_KEY_REQUIRED_IF_EXECUTING_OUTSIDE_NGC'

accept_header='Accept: application/json'

content_type_header='Content-Type: application/json'

data=$'{

"messages": [

{

"role": "user",

"content": "Which number is larger, 9.11 or 9.8?"

}

],

"stream": true,

"model": "deepseek-ai/deepseek-r1",

"max_tokens": 4096,

"presence_penalty": 0,

"frequency_penalty": 0,

"top_p": 0.7,

"temperature": 0.6

}'

response=$(curl --silent -i -w "\n%{http_code}" --request POST \

--url "$invoke_url" \

--header "$authorization_header" \

--header "$accept_header" \

--header "$content_type_header" \

--data "$data"

)

echo "$response"第二步:创建api_keys

点击Get API Key创建一个api_keys

第三步:发送测试对话

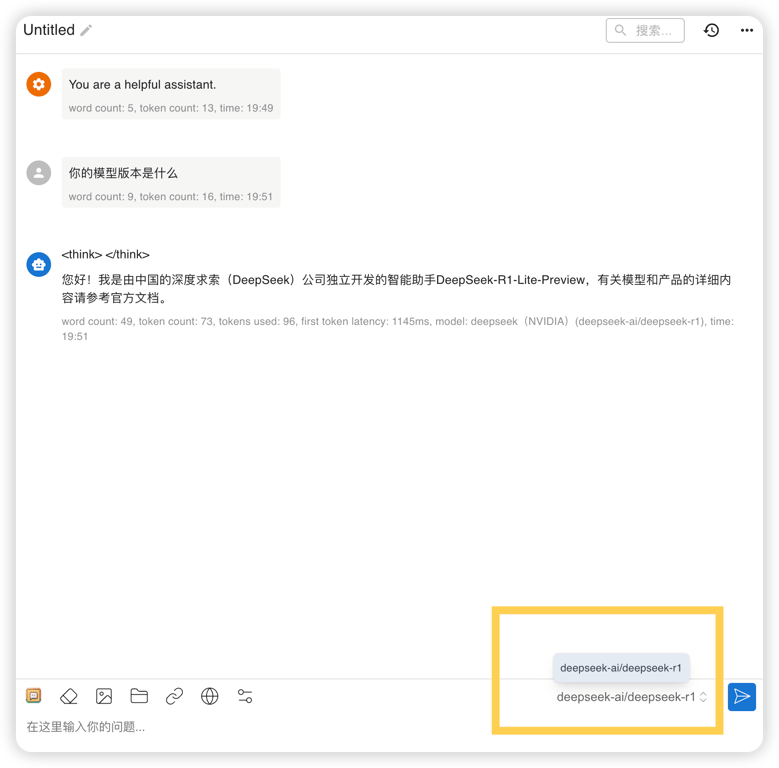

启动一个AI对话客户端,这里以chatbox举例

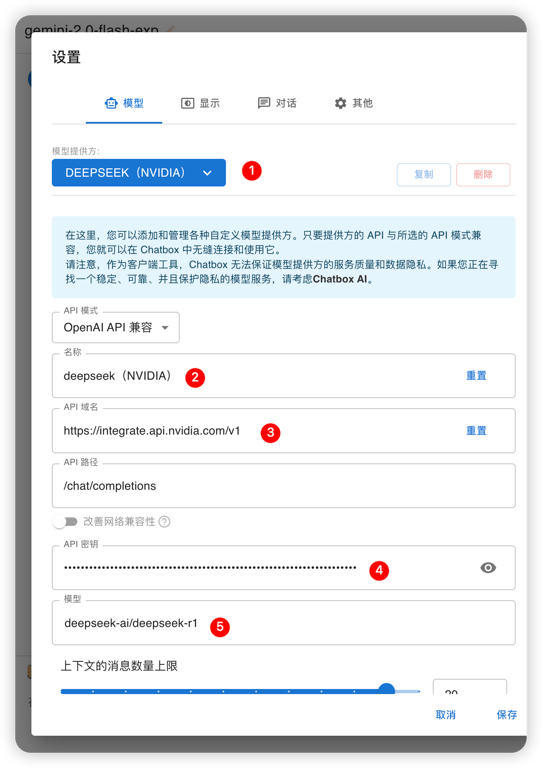

进入设置页面,在模型提供方下拉框处添加自定义模型,按下以下规则填写其余项并保存

名称:deepseek(nvidia)

API密钥:第二步中申请到的api_keys

模型:deepseek-ai/deepseek-r1

在对话窗口右下角切换模型为英伟达的deepseek-ai/deepseek-r1模型

发送一条消息,如果能获得回复,即调用成功

<think></think>标签内的文本表示深度思考